Es gibt verschiedene Methoden, digitale Werke gezielt für KI-Training und KI- Suche unbrauchbar oder sogar schädlich zu machen.

Es gibt verschiedene Methoden, digitale Werke gezielt für KI-Training und KI- Suche unbrauchbar oder sogar schädlich zu machen.

Data Poisoning

Eine Form Werke vor KI Training zu schützen ist das sogenannte Data Poisoning. Dabei werden die Pixel eines Bildes unsichtbar verändert, bevor es online veröffentlicht wird. Für das menschliche Auge bleibt das Bild unverändert, doch KI-Systeme interpretieren es falsch oder können es gar nicht verwerten.

Wird Data Poisoning systematisch und in großem Umfang eingesetzt, kann dies die Qualität ganzer generativer KI-Modelle beeinträchtigen. Die manipulierten Bilddaten führen zu falschen Lernergebnissen, etwa zu unpassenden oder fehlerhaften Ausgaben bei Text-zu-Bild-Prompts.

Für Künstler*innen bietet diese Technik eine Möglichkeit, ihre Werke weiterhin im Netz zu zeigen, ohne dass KI-Systeme damit trainiert werden können. So entsteht eine Form des Widerstands gegen die automatisierte Verwertung der Arbeit von Kunstschaffenden.

Tools für Data Posioning

Glaze

Glaze verwendet Machine-Learning-Algorithmen, um minimale Änderungen an Kunstwerken zu berechnen, sodass sie für menschliche Augen unverändert erscheinen, aber für KI-Modelle ein völlig anderes Werk darstellen. Dies führt dazu, dass die KI das Werk falsch einkategorisiert. Die Veränderungen, die Glaze vornimmt, befinden sich sozusagen auf einer Ebene, die wir nicht sehen können, sodass auch Screenshots des Bildes oder andere Bearbeitungsmethoden die Änderung nicht rückgängig machen können.

Wie?

Tutorials:

Users Guide von Glaze (Nur auf Englisch): Link

Direkt zum Tool: Link

Glaze als Webtool: Link

(Für Personen mit wenig GPU oder ohne eigenen Computer)

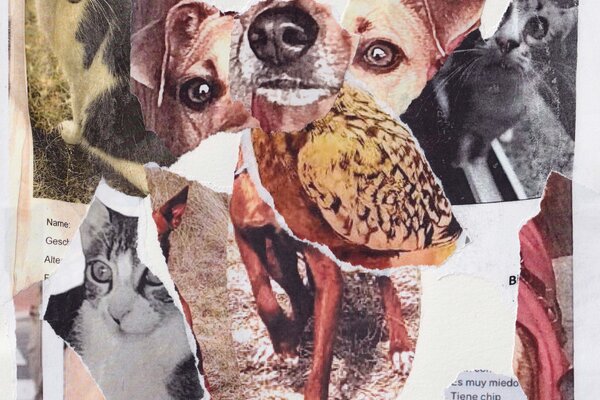

Nightshade

Nightshade erzeugt Veränderungen am Werk, die für menschliche Betrachter*innen wie eine leichte Schattierung wirken. Für die KI entsteht ein völlig neues Bild. Erkennt ein Mensch beispielsweise eine Kuh, erscheint das Bild für die KI auf einmal als Ledertasche. Auf Dauer gelangt die KI so zu der falschen Erkenntnis, dass es sich bei einer “Kuh” um eine Ledertasche handelt und produziert zunehmend falsche Ergebnisse. Durch den Schaden bei der Nutzung unlizenzierter Werke wird die Lizenzierung der Werke für KI Anbieter*innen zu einer realistischen Alternative.

Anleitung (auf Englisch): Link

Direkt zum Tool: Link

Dynamisches Wasserzeichen

Das dynamische Wasserzeichen bettet einen unsichtbaren oder halb sichtbaren Code in den digitalen Inhalt ein. Dieser kann sich, im Gegensatz zu normalen Wasserzeichen, im Laufe der Zeit oder als Reaktion auf bestimmte Situationen dynamisch verändern.